解锁深度学习新边界:双锐炫A770显卡助力32B DeepSeek R1极速部署

今年春节期间,科技圈最引人注目的一个名词当属“DeepSeek”。这款突然崛起的开源大语言模型(LLM)让人工智能以惊人的速度普及到亿万普通用户中,让更多人开始了解并使用大模型。然而,随着DeepSeek的爆火,其在线服务——无论是手机端、APP还是网页端——都频繁出现服务器繁忙、需要等待的现象,这正是云端部署的一大弊端,常常伴随排队、延迟以及隐私与安全方面的隐忧。

本地部署大语言模型正逐渐成为用户的热门选择。相比于依赖云端服务,本地部署不仅能避免在线排队,实现即时推理,还能提供更高的稳定性和安全性。这种模式有效降低了数据泄露和服务器故障的可能性,尤其适合处理一些敏感或机密信息,让用户能够在本地环境完成离线操作,从而更好地保护个人隐私。 在我看来,本地部署LLM为用户带来了更多自主权和灵活性。它不仅解决了云端可能存在的延迟问题,还减少了对网络连接的依赖。对于企业和个人而言,这无疑是一个重要的优势。不过,我们也需要注意到,本地部署意味着更高的硬件投入和技术维护成本。因此,在选择是否采用这种方式时,用户应根据自身需求权衡利弊。总体来说,本地部署大语言模型的发展方向值得期待,未来可能会进一步推动人工智能技术的普及与应用。

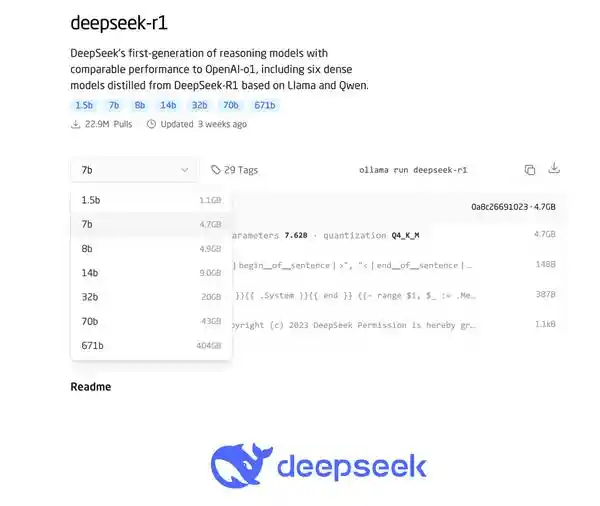

(DeepSeek R1模型提供从1.5b到671b多个参数量版本)

本地部署大模型确实对硬件有较高要求,尤其是在GPU的算力方面。显存容量和计算性能直接影响推理效率,而为了实现更全面的推理效果,7B参数的模型显然无法满足需求,14B、32B乃至更大规模的70B模型成为更优选择。然而,这类高性能显卡的价格令人望而却步。以RTX 4090为例,即便它拥有24GB显存,目前的售价仍高达一万七千元,这对普通用户来说无疑是一笔不小的开支。 在我看来,这种高昂的成本限制了更多人接触和使用先进AI技术的机会。一方面,企业需要投入大量资金来搭建基础设施,这无疑提高了行业门槛;另一方面,个人开发者或小型团队则可能因预算不足而被迫放弃尝试。如何平衡技术进步与普及化之间的关系,或许是未来需要重点关注的方向。或许可以通过云服务模式降低初期投入,或者推动更高效的算法优化,减少对硬件资源的依赖,让更多人能够享受到人工智能带来的便利。

本文将介绍如何使用一万元的预算来实现32GB显存的本地DeepSeek R1大模型部署。其中显卡部分使用两块英特尔锐炫A770 16GB显卡组成,成本不到四千元,价格相当亲民,可以有效控制预算。通过使用IPEX-LLM在Ubuntu操作系统下部署32B参数的DeepSeek R1大模型,实现高效的本地推理,实测生成阶段的Avg Generation Throughput可以稳定在26 tokens/s以上。无论是在上下文生成还是代码生成实例中,都表现出了极强的效率,并且整套系统的功耗控制在800瓦以下。

我们利用DeepSeek模型编写贪吃蛇游戏代码,以此来评估整体推理性能,并且全程在本地环境中运行。

输入Prompt为:

【请用html写个贪吃蛇游戏的代码,需要包含以下功能:

1. 使用键盘上的上下左右箭头键控制蛇的移动方向

2.蛇能够自行向前行进,当它捕获红色食物时,身体会延长并且得分随之提升。

3. 当蛇碰到墙壁或自己时,游戏结束并显示得分

4. 点击重新开始按钮可以重置游戏并重新开始

游戏规则:

·蛇不能碰到墙壁或自己,否则游戏结束

·每吃一个食物,得分增加10分

·食物不会出现在蛇的身体上】

经过约15秒的思考过程,DeepSeek模型便开始生成代码,整个过程仅花费1分钟便全部完成。尤其值得一提的是,利用OpenWebUI图形界面进行交互时,在代码执行完毕后会弹出一个预览窗口,用户可以通过键盘方向键操控蛇的移动,吃到食物以获取分数。一旦蛇撞上墙边或自身,游戏便会结束。这种直观的操作方式让编程变得更加便捷和有趣。

(贪吃蛇代码调整演示)

如果代码存在不足之处,我们依然可以通过指令让DeepSeek不断优化,比如初次生成的代码中,蛇的移动速度过快,经过调整后,将其移动的时间间隔增加到了200毫秒,这样操作起来就顺手多了。总之,在本地部署的DeepSeek环境下,你可以根据需求随时提出修改意见,从而提高工作效率。

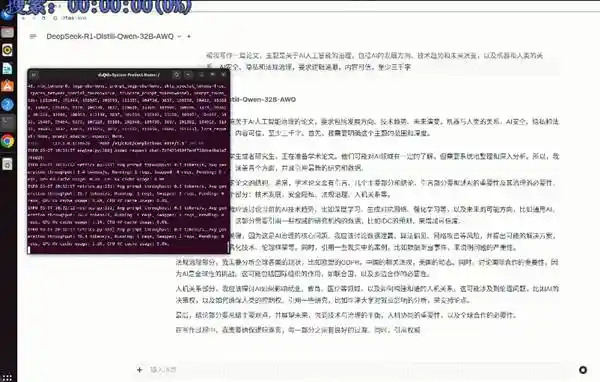

在最近的一次文章生成测试中,我们发现DeepSeek R1模型展现出了令人印象深刻的表现。在大约3000字的文章生成任务中,其Prefill阶段的吞吐量最高可达28.1tokens/s,而生成阶段的平均输出速度约为25tokens/s。按照一个中文字符相当于0.6个token来计算,该模型的实际生成速度约为每秒20个汉字。对比人类平均每分钟阅读700字的速度,这套本地部署的模型不仅展现了极高的效率,更是在速度上远远超过了普通人的阅读能力。 这一成果无疑标志着人工智能技术在文本生成领域取得了重要突破。如此高效的生成速度意味着DeepSeek R1不仅能够快速完成大量内容的创作,还可能在实时应用场景中发挥重要作用。例如,在新闻报道、数据分析报告或是社交媒体内容生成等方面,这种高速度和高效率都将极大提升工作效率。 然而,值得注意的是,尽管技术进步带来了诸多便利,我们也需要关注随之而来的伦理与社会影响。例如,如何确保生成内容的质量与真实性?如何防止滥用这项技术造成信息泛滥或虚假新闻传播?这些都是未来发展中需要深入思考的问题。 总体而言,DeepSeek R1模型的成功展示了人工智能在未来信息处理领域的巨大潜力。但同时,我们也应积极应对挑战,确保技术发展能更好地服务于社会,造福于人类。

本次部署过程使用硬件平台配置一览:

在构建高性能计算平台时,硬件的选择至关重要。以当前Intel桌面平台为例,搭配酷睿Ultra9285K处理器与Z890主板虽然能提供顶级性能,但实际应用中可能并不完全必要。毕竟,大模型的运行主要依赖GPU,对CPU的需求相对较低,因此选用酷睿Ultra7或Ultra5处理器同样能够满足需求。Z890主板的优势在于其支持至少两个PCIe显卡插槽,并且能够通过两条x8通道拆分来最大化显卡的带宽表现。此外,如果计划采用封闭式机箱,则需特别留意显卡与机箱内部结构的兼容性,避免出现物理干涉的问题。 个人认为,在硬件配置上追求极致并非总是明智之举。尤其是当核心任务已经明确集中在GPU处理时,适度降低CPU等级不仅能够有效控制成本,还能在一定程度上减少不必要的能耗。当然,选择合适的主板同样关键,它直接影响到整个系统的稳定性和扩展性。至于机箱设计,则需要综合考虑散热效率与空间布局等因素,确保硬件之间不会因安装不当而产生摩擦或损坏。总之,在规划软硬件部署时,既要关注性能指标,也应兼顾性价比与实用性。

内存方面,最好选择大容量高速内存,以提升模型的加载和调用效率。我们使用的24GB*2 CUDIMM内存效率还不错,只不过CUDIMM内存由于CKD原因现在价格较贵,并且主要针对超频有利,因此使用普通的8000 MT/s DDR5内存也是没问题的。因此如果进一步调整配置,是能做到整体硬件开销在万元之内的,相比单24GB/32GB显存显卡的方案那可是太实惠了。

值得注意的是电源,因为需要同时接入两块A770显卡(此次使用的一块A770还是来自蓝戟的超频版本),单卡TGP约在200瓦左右,加上我们使用的是Ultra 9处理器,因此选择了鑫谷的GM1250瓦电源,更主要的原因是其支持4个PCIe 8Pin供电接口,能够满足两块A770双8+6pin的供电需求。

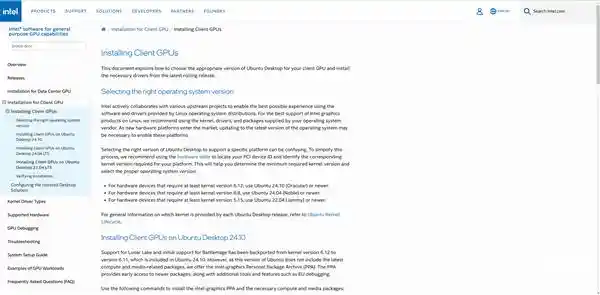

至于操作系统,其实在Windows系统下也能实现双锐炫A770显卡的部署,只不过由于操作系统差异和机器学习架构的效率不同,其运行效率不如在Linux系统下更快。因此我们使用Ubuntu 22.04系统,这个版本已经由英特尔官方提供来了驱动适配和支持,兼容性很好。当然,如果你使用其它版本的Linux系统,可以参看intel官方支持页面进行操作。

近期,我尝试部署了一款基于Q4量化的DeepSeekR1-32B大语言模型,这一模型可以从Hugging Face或魔塔社区轻松获取。在实际操作中,我发现通过OpenWebUI搭建图形化界面不仅便于实时监控后台运行状态,还能更直观地展示模型的功能与效果。这款模型的表现让我印象深刻,它在处理复杂任务时展现出强大的能力,尤其是在生成高质量文本方面,能够满足多种应用场景的需求。 我认为,随着大语言模型技术的不断进步,这类工具正在逐渐成为行业发展的新趋势。对于需要高效生成内容的企业和个人来说,这样的模型无疑提供了极大的便利。不过,我也注意到,在享受技术带来的便捷的同时,我们也应该关注数据安全和隐私保护等问题。希望未来开发者能够在提升性能的基础上,进一步加强模型的安全性和合规性,让技术更好地服务于社会。

需要特别留意的是,我们利用了一块锐炫A770显卡的DP接口来进行显示输出,这在理论上会对显卡处理大模型任务的效率造成一定的影响。假如通过局域网的方式远程访问后端服务器,可以让两块锐炫A770显卡专注于承担大模型的计算任务。这一点需要在此予以说明。

通过本地部署的方式,我们成功将两块英特尔A770显卡的显存进行叠加利用,从而支持了32B参数DeepSeekR1大型模型的离线运行。这一实践证明,其运行效率令人满意,不仅能够高效完成推理任务,还为用户提供了丰富的功能体验。对于有同样需求的人来说,这无疑是一条值得参考的技术路径,有助于构建属于自己的高性能大模型服务器。 在我看来,这种技术探索的意义在于它降低了高端AI应用的门槛。过去,要运行如此大规模的模型往往需要依赖云端资源或昂贵的专业设备,而现在通过合理的硬件组合与优化配置,普通用户也能在本地环境中实现高效运转。这不仅增强了数据处理的安全性,也提高了工作的灵活性。未来,随着更多类似方案的涌现,相信会有越来越多的人加入到个性化AI解决方案的开发中来。

免责声明:本站所有文章来源于网络或投稿,如果任何问题,请联系648751016@qq.com

页面执行时间0.014626秒