小米开源MiDashengLM-7B,开启人车家智能交互新纪元

8月4日,小米正式发布并开源其声音理解大模型MiDashengLM-7B,该模型被视为小米“人车家全生态”战略中的核心技术支撑。 小米此次推出的声音理解大模型,不仅体现了其在人工智能领域持续深化布局的决心,也进一步强化了其在智能生态体系中的技术基础。开源举措则有助于推动技术的广泛应用与生态共建,显示出小米在开放合作方面的积极态度。这一进展对于提升用户体验、拓展智能场景具有重要意义。

MiDashengLM具备跨领域理解语音、环境声音和音乐的能力,不仅能够识别用户周围发生的情况,还能深入分析其中的潜在含义,从而提升用户场景理解的广泛适用性。

基于MiDashengLM的模型通过自然语言和用户交互,为用户提更人性化的沟通和反馈,比如在用户练习唱歌或练习外语时提供发音反馈并制定针对性提升方案,又比如在用户驾驶车辆时实时对用户关于环境声音的提问做出解答,其应用场景有广阔的空间。

MiDashengLM凭借高效的推理部署性能,正在为智能座舱、智能家居等应用场景提供更强的支撑,进一步推动多模态交互体验的升级,助力相关领域实现更智能化的发展。 在当前技术快速迭代的背景下,具备高效推理能力的模型正成为推动智能设备升级的关键力量。MiDashengLM的推出,不仅提升了系统响应速度与交互流畅度,也为用户带来了更加自然、便捷的使用体验。随着多模态交互技术的不断成熟,这类模型将在更多场景中发挥重要作用,成为智能生态建设的重要一环。

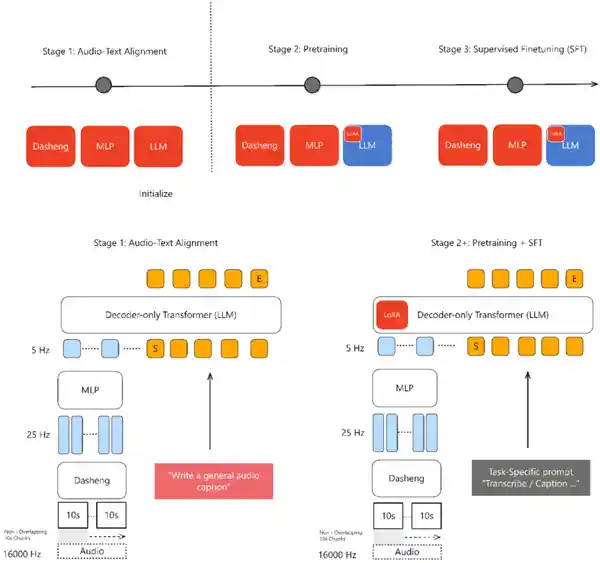

基于XiaomiDasheng音频编码器和Qwen2.5-Omni-7BThinker自回归解码器构建的系统,通过通用音频描述训练策略,实现了对语音、环境声音和音乐的统一理解。这一技术组合展现了在多模态音频处理领域的深度融合与创新。 从技术角度看,这种架构不仅提升了音频内容的理解能力,也为未来智能语音交互、音视频分析等应用场景提供了更强大的基础支持。尤其是在跨类型音频处理方面,统一的理解机制有助于提升系统的泛化能力和实际应用价值。

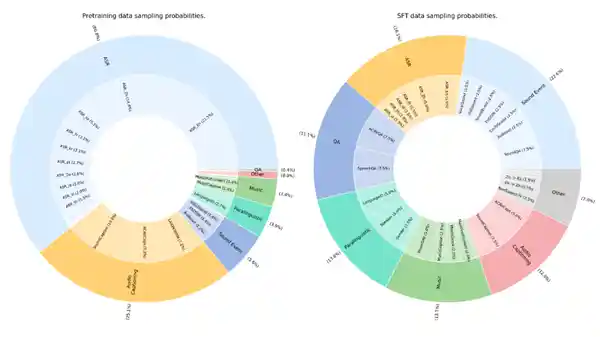

训练数据完全来源于公开数据集,包含五大类共计110万小时的资源,采用Apache License 2.0协议进行发布,允许用于学术研究和商业用途。 这一数据集的开放性为人工智能技术的发展提供了重要支撑,尤其在推动技术普惠方面具有积极意义。通过允许商业应用,不仅有助于技术成果的转化,也鼓励了更多企业和机构参与到AI生态建设中。同时,数据来源的透明性和合规性也为模型的可信度和可持续发展奠定了基础。

核心优势:

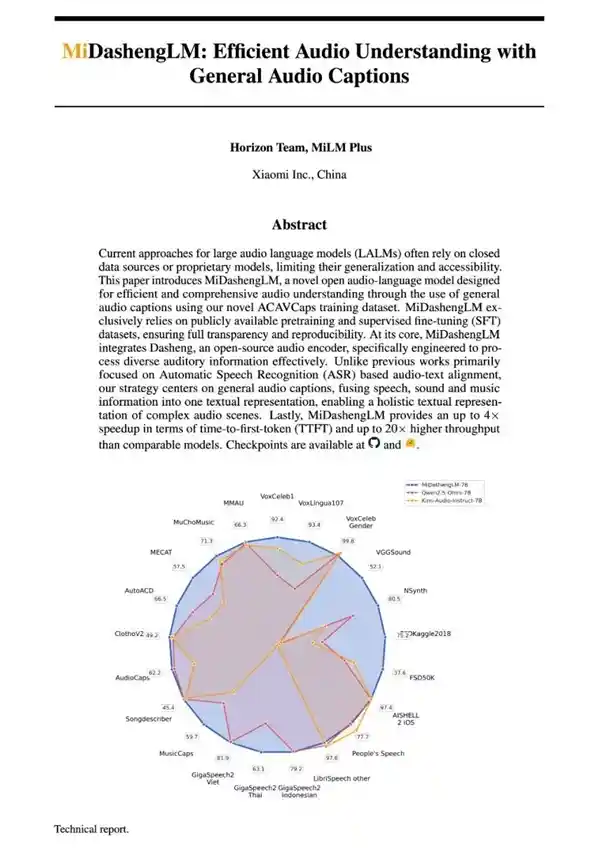

性能领先:在22个公开评测集上取得多模态大模型的最优成绩(SOTA),在音频描述、声音理解以及音频问答任务中表现优异,同时具备实用的语音识别功能。其音频编码器XiaomiDasheng在X-ARESBenchmark多项关键任务中,特别是在非语音类理解任务上,表现明显优于Whisper。

推理效率高:单样本推理的首Token延迟(TTFT)仅为业界先进模型的1/4;在同等显存条件下,数据吞吐效率是业界先进模型的20倍以上。在80GB GPU上处理30秒音频并生成100个token时,batchsize可达512,而同类模型在batchsize为16时即出现显存溢出问题。 从技术角度来看,这一性能突破不仅体现了模型架构优化的成效,也反映出在资源利用效率上的显著提升。对于实际应用而言,这意味着在相同硬件条件下,系统能够处理更大量的并发请求,从而大幅提升服务能力和用户体验。这种进步对语音识别、实时交互等场景具有重要意义,也为未来更复杂任务的部署提供了更强的基础支撑。

训练方式创新:引入通用音频描述对齐机制,借助非单调的全局语义映射,深入挖掘音频场景中的深层语义关系,突破传统ASR转录数据对齐的限制,提升数据使用效率,同时能够有效捕捉说话人情感、空间混响等重要声学特征。

免责声明:本站所有文章来源于网络或投稿,如果任何问题,请联系648751016@qq.com

页面执行时间0.009612秒