突破瓶颈,释放潜能:深度搜索引擎DeepSeek-R1本地部署助力服务器高效运转

近期,国产大模型DeepSeek-R1在市场上异军突起,吸引了大量用户的关注。随着其热度和用户量的激增,服务器过载的问题也日益凸显,频繁出现访问延迟甚至无法连接的情况。 这一现象反映了DeepSeek-R1在短时间内获得了市场的广泛认可,但也暴露出公司在基础设施建设上的不足。如何平衡快速发展与稳定服务之间的关系,将是DeepSeek-R1未来发展的重要挑战之一。希望该公司能够及时优化服务器架构,提升用户体验,以更好地满足用户需求。

为了避开服务器拥堵的问题,本地部署DeepSeek-R1成为了理想的选择,这样不仅能降低对网络连接的需求,还能提升数据的安全性。下面,我们就来了解一下具体的操作步骤。

1、下载并安装Ollama

Ollama作为一款开源的本地化大模型部署工具,确实为用户提供了极大的便利。通过它,用户可以轻松地安装、配置和运行各种开源大模型,这无疑大大降低了技术门槛。对于那些希望在不依赖云端服务的情况下,自行部署和管理大模型的开发者和研究者来说,Ollama无疑是一个非常实用的选择。它不仅简化了复杂的部署流程,还保证了数据的安全性和隐私性,使得更多人能够参与到人工智能的研究与应用中来。

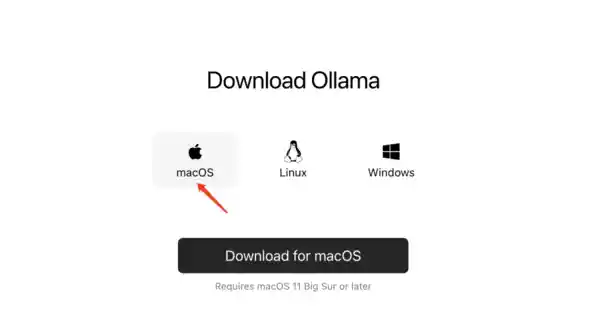

访问Ollama官方网站(网址为https://ollama.com/download),该平台兼容macOS、Linux和Windows系统,根据您的电脑操作系统选择相应的版本进行下载。

以小编使用的Macbook Air为例,选择“macOS”,点击下载。

下载完成后,双击安装程序并按照提示完成安装。如果在顶部菜单栏中看到这个羊驼图标,即表示Ollama在运行状态。

2、安装DeepSeek-R1

接下来,我们回到Ollama官网,在左上角找到 “Models” 点击进入。

在搜索框中输入deepseek-r1,找到“deepseek-r1”,点击进入详情页。

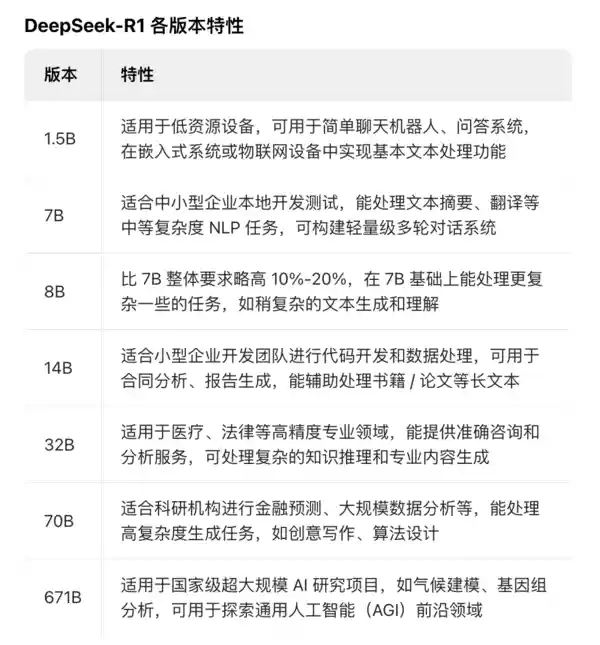

DeepSeek-R1系列拥有多种类型,每种类型名称后面跟着的1.5B、7B、14B等数字代表的是模型的参数量。对于广大用户来说,可以根据自己的电脑硬件配置来选择合适的参数版本。在实际应用中,硬件配置较高的用户可以选择参数更多的版本,以获得更好的性能体验。而对于硬件条件一般的用户,则可以选择参数较少的版本,这样既能够满足基本需求,又不会因为资源占用过多而导致系统运行缓慢。总体而言,DeepSeek-R1系列为不同层次的需求提供了多样化的选择,让用户可以根据实际情况进行合理选择。

需要注意的是,模型的参数量与处理数据及生成内容的复杂程度确实存在密切联系。随着参数量的增加,模型能够处理更加复杂的任务,并且生成的内容也会更加丰富多彩。然而,这也意味着更高的硬件配置需求。在我看来,这种技术的进步无疑为人工智能领域带来了更多的可能性,使得机器能够更好地理解和模拟人类的思维方式。不过,随之而来的计算资源消耗问题也不容忽视,我们需要找到一种平衡点,在保证性能的同时降低对硬件的要求。

小编选择的是8b版本,并复制“ollama run deepseek-r1:8b”命令。

调出电脑的“启动台”,搜索“终端”并点击进入,将命令粘贴到“终端”窗口,按下回车键,等待安装完成。

3、下载并安装Chatbox

Chatbox是一款融合了人工智能技术与用户友好界面的智能对话工具,适用于Windows、MacOS、Linux、Android、iOS以及网页端,能协助用户高效完成各项任务。

进入Chatbox官方网站(网址为https://chatboxai.app/zh),选择符合您电脑系统的版本进行下载,并完成安装过程。

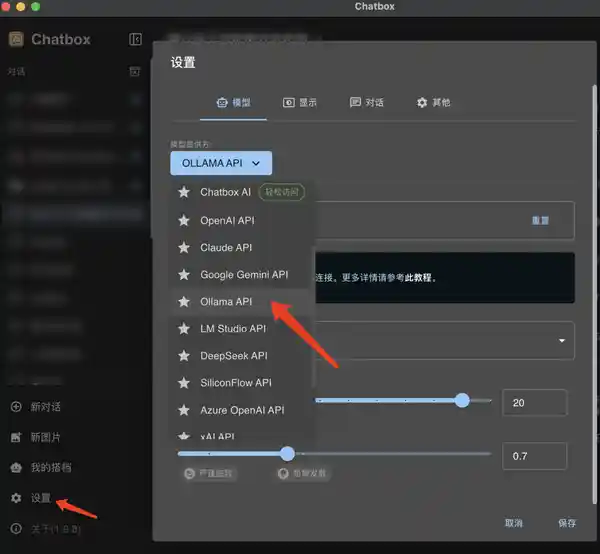

下载完成后,打开Chatbox,点击“设置”,在“模型提供方”中选择“OLLAMA API”。

在“模型”列表中,选择已经安装好的“deepseek-r1:8b”,点击“保存”。

完成以上三个步骤,就可以在Chatbox中,与DeepSeek-R1展开对话了。

写在最后:

在当今人工智能迅猛发展的时代,掌握大模型的使用技巧无疑能使我们在信息处理和知识获取方面获得竞争优势。希望大家在使用过程中能够充分发挥DeepSeek-R1的潜能,取得更多成就。

免责声明:本站所有文章来源于网络或投稿,如果任何问题,请联系648751016@qq.com

页面执行时间0.016752秒