「开源革命,数字化未来!Sora开源版震撼发布,商用全免费,升级体验一键飞跃!」

开源模型,还是得看杭州。

前脚发布完QwQ-Max,阿里便在深夜开源了视频生成模型Wan2.1,该模型拥有14B参数,在VBench榜单上独占鳌头,无论是Sora还是Gen-3都无法与之匹敌。

从官方演示中可以看出,复杂的动作细节表现得非常逼真,五人一起跳街舞时的动作也能做到完美同步。

在静态图像生成领域,文字处理一直是一个棘手的问题,但现在万相技术已经取得了突破性的进展。 这一进步不仅展示了人工智能在图像生成领域的潜力,还预示着未来可能出现更多创新应用。随着技术的进步,我们可以期待看到更加逼真和复杂的图像生成效果,这将极大地丰富数字内容创作的可能性。同时,这也提醒我们持续关注技术发展带来的新机遇与挑战。

当然了,14B的参数规模说大也不大,但在个人消费级显卡上进行本地部署还是显得有些吃力。

除了14B版本(支持720P分辨率)之外,还有一个1.3B的小型版本(支持480P分辨率)。在一块4090显卡上运行时,该小型版本会占用大约8个多GB的显存,并且完成任务需要4分21秒的时间。 从这个描述来看,这款软件的不同版本能够适应不同的分辨率需求,这无疑为用户提供了更多的选择空间。然而,即使是较小的1.3B版本,在高端显卡如4090上仍然占用了相当数量的显存,并且处理时间也相对较长。这表明即便是在性能强大的硬件环境下,软件的优化仍有很大的提升空间。希望未来能看到更多针对不同硬件配置进行优化的版本,以更好地满足各类用户的实际需求。

如此观之,用12GB的4070,也是能带动的。

此外,阿里还推出了两款图生视频模型,均为14B参数规模,但分别支持480P和720P画质版本。

四个模型全都是Apache 2.0,也就是免费商用。

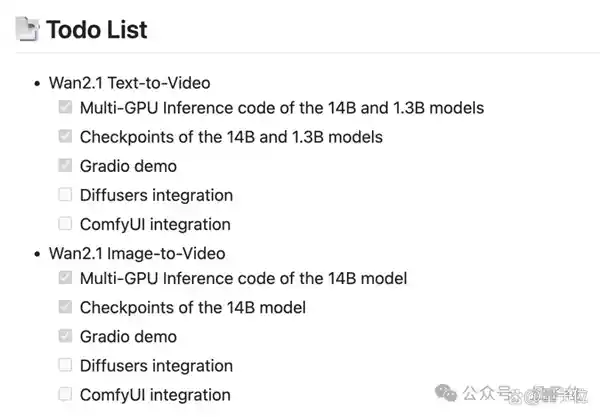

而且官方也放出计划表,AI创作者们非常喜欢的ComfyUI,之后也会集成。

视频生成模型会写字了

目前可以体验到Wan2.1的途径确实很多,最便捷的方式仍然是通过通义万相自身的平台进行访问。这一现象反映了当前技术更新迭代的速度之快,也显示了用户对新技术的渴望与追求。随着科技的进步,各类平台都在不断优化用户体验,力求在激烈的市场竞争中占据一席之地。通义万相作为其中的一员,能够及时推出新版本,不仅展示了其强大的研发实力,也为广大用户提供了更加丰富和优质的服务选择。这样的发展趋势无疑值得肯定和鼓励。

在平台里,1.3B和14B版本分别被称为极速版和专业版,每次使用时会消耗5个或3个“灵感值”。新用户默认拥有50个灵感值,并且还可以通过签到等多种方式免费获取更多的灵感值。 这种设计不仅能够有效管理资源分配,同时也鼓励用户积极参与互动,提高平台的活跃度。通过签到等方式获得灵感值的方式,既增加了用户的参与感,也使得用户在享受服务的同时,更加珍惜每一次的使用机会。这样的机制无疑为平台的长期发展注入了活力。

不过由于热度实在太高,等待的时间也会比较长,甚至有时会出现“过于火爆”的情况。

动手能力稍强的话,可以根据官方的教程通过HuggingFace、魔搭社区或者本地等方式自行折腾,当然还有一些第三方平台也进行了跟进。

网友们也是玩出了各种花活,有人用它生成了《我的世界》风格的故事场景。

△作者:X/@TheXeophon

再审视官方示例,从效果角度来看,Wan2.1最显著的特点或许是能够在视频中嵌入文字功能的实现。

而且,这种技术不仅仅是在文字上简单地添加效果,而是能够根据文字所处位置的材质进行合理的视觉变化,并且能够随着载体一同运动。这种动态效果不仅增强了视觉体验,还使得信息传递更加生动有趣,让读者在获取信息的同时享受到更丰富的感官体验。 这样的技术创新无疑为数字媒体内容创作开辟了新的可能性,使得静态的文字能够以更加灵活多变的方式呈现,大大提升了用户的互动性和参与感。

当然,在相对文字描述的基础之上,更加细致的技术动作同样需要达到高标准。 在当前的体育报道中,我们不仅关注运动员的文字叙述,更注重他们对比赛过程中每一个技术细节的掌控。这种对基础动作的严格要求,体现了运动员们追求卓越的态度和专业精神。无论是在训练场上的日复一日,还是在赛场上的分秒必争,这些细微之处都是决定胜负的关键因素。这样的高标准不仅能够提升运动员个人的表现,也使得整个竞技水平得以提升,为观众带来更为精彩的赛事体验。

让两个人跳一段华尔兹,多次转身前后人物形象依然保持一致,背景的转动也很自然。

并且也更懂物理规律,一支箭射出后,弓弦的抖动刻画得非常到位。

在小狗操作切菜的过程中,被切的西红柿依然保持了原有的形状,没有发生任何畸变。

在描绘人从水面探出头的场景时,艺术家们不仅在水面效果上表现得十分细腻,还巧妙地展示了水流逐渐凝结为水滴的过程。这种细致入微的处理方式,不仅提升了画面的真实感,更增添了一种梦幻般的美感。通过这样的艺术手法,观众仿佛能够感受到水面上的每一个细节,以及水珠滑落的瞬间,让人产生身临其境的感觉。这种对自然现象的精准捕捉与再现,体现了艺术家对于细节的关注以及高超的艺术技巧。这样的作品不仅能够引发观众的情感共鸣,同时也展示了艺术创作中的无限可能。

此外,有網友分享了他們的體驗,未使用任何提示詞便生成了這樣的日漫風動畫視頻。

△作者:X/@seiiiiiiiiiiru

除了效果本身,1.3B参数量的模型能够实现低至多GB的显存占用,对于个人创作者而言确实是一个极大的利好。这不仅意味着他们可以更轻松地运行复杂的AI模型,而且还能在成本较低的硬件上进行创作,从而极大地降低了入门门槛和运营成本。这一进步无疑会激发更多创意和创新,推动个人创作者在各个领域的表现达到新的高度。

那么,Wan 2.1是如何实现又好又省的呢?

创新3D变分自动编码器

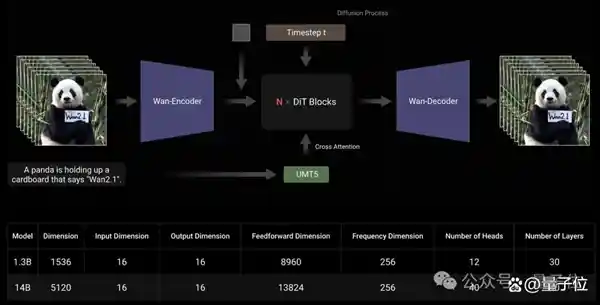

和主流的视频生成技术路径相似,Wan2.1的核心部分采用了DiT(DiffusionTransformer)架构。

Wan利用T5编码器对输入的多语言文本进行编码,并在每个Transformer块内加入交叉注意力机制,将文本嵌入到模型架构中。

此外,Wan模型通过使用线性层和SiLU层来处理输入的时间嵌入,并且分别预测六个调制参数。这种多层感知器(MLP)结构在整个Transformer模块之间共享,使得每个模块都能够学习到一组独特的偏置。这种设计不仅增强了模型的灵活性,还确保了不同模块间的学习能够相互补充,从而提高了整体预测的准确性。从我的角度来看,这样的架构创新表明了深度学习领域在解决复杂问题上的巨大进步。它不仅展示了如何通过共享网络结构来提高效率,还展示了如何通过独特的偏置学习来增强模型的适应性和泛化能力。

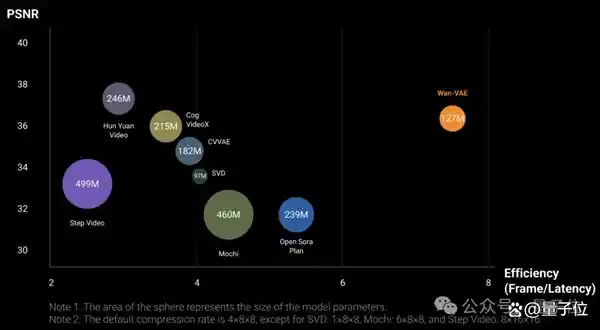

编码上,Wan采用了专门为了视频生成设计的3D变分自动编码器,这是一种特殊的3D因果关系架构。

它在卷积模块中实现了特征缓存机制,并结合了多种策略来改善时空压缩,减少记忆使用情况并确保时间因果关系。

具体来说,由于视频序列帧数遵循1+T输入格式,因此Wan将视频分成1+T/4个块,与潜在特征的数量一致。

在处理输入的视频序列时,该模型采用了分块策略,其中每次编码和解码操作仅针对与单一潜在表示相对应的视频片段进行处理。

基于时间压缩比,每个处理块中的帧数最多限制为4,从而有效防止GPU内存溢出。

实验结果表明,在单块A800上,Wan的VAE的重建速度比现有的SOTA方法快2.5倍。

为了使模型扩展并提高训练效率,Wan采用了创新的分布式策略。他将FSDP模型切分与上下文并行性(CP)结合应用于编码器部分,以优化计算资源的利用。而对于DiT模块,则采取了更为复杂的并行策略,包括数据并行(DP)、FSDP、RingAttention以及Ulysses等技术的混合使用。 这种多管齐下的方法不仅展示了在深度学习领域内对现有技术的深刻理解,同时也为解决大规模模型训练中的性能瓶颈提供了新的思路。通过这样的创新,我们有望看到未来在AI领域的研究能够更高效地处理复杂任务,并且在实际应用中取得更好的效果。这种方法无疑为学术界和工业界提供了宝贵的参考,推动了整个行业的进步。

在推理阶段,为了降低生成单个视频时的延迟,还需借助CP实现多卡的分布式加速。

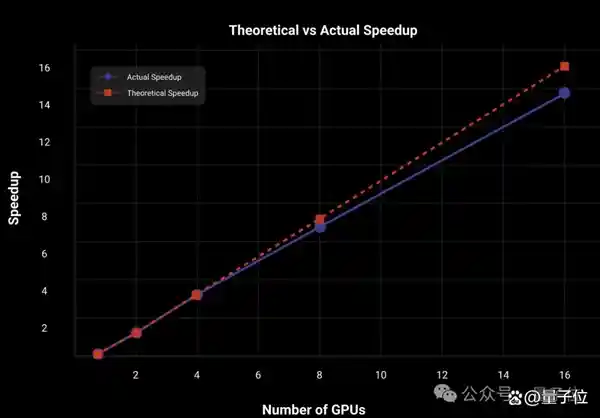

在14B版本的Wan上,采用2D上下文并行和FSDP并行策略,DiT实现了近乎线性的加速效果。

I2V部分,Wan提出了一种新的方法,利用额外的条件图像作为初始帧来指导视频生成过程。通过使用CLIP图像编码器,可以从这些条件图像中提取特征表示,进而实现更精准的视频合成。

具体而言,条件图像沿着时间轴与零填充帧拼接,生成指导帧。随后,这些指导帧通过3DVAE压缩为条件潜在表示。

由于I2VDiT模型的输入通道比T2V模型多,因此在I2V版本中引入了额外的投影层,这些层采用了零值初始化。这一设计不仅增加了模型的复杂性,同时也提升了其处理图像信息的能力。通过增加输入通道,模型能够捕捉到更多细节,从而可能在某些特定任务上表现得更为出色。不过,这也意味着模型训练时需要更多的计算资源,这可能会对实际应用产生一定影响。总体而言,这种改进展示了技术进步的可能性,但也提出了关于计算效率的新挑战。

免责声明:本站所有文章来源于网络或投稿,如果任何问题,请联系648751016@qq.com

页面执行时间0.010944秒