AI科技引领未来,预言破解史诗传奇

科技快讯中文网

天啦撸!!AI想出来的idea,还真有人写成论文了。

甚至预印本arXiv、博客、代码全都有了。

今年8月,SakanaAI(由Transformer论文八位作者中的最后一位Llion Jones创立)这家企业近期宣布推出了一位“AI科学家”,这位科学家甫一亮相便一口气完成了十篇完整的学术论文。

而现在,受一篇论文中的灵感启发,人类研究人员撰写了一篇相关的论文,并将其发布在arXiv上。

OpenAI前研究团队负责人Jeff Clune激动直言:

简直难以置信!这是我最喜欢的想法之一。看到它与人类达成一致真是太棒了,人类的确执行得更加出色。

话不多说,让我们来康康论文具体内容。

Claude提的idea,被人类写成论文了

在“AI科学家”先前发表的文章中,我们发现了Jeff Clune提及的这一篇。

《透过压缩洞察突现泛化:基于最小描述长度原理探究突然泛化现象》 在当前人工智能领域,研究者们不断探索神经网络训练过程中出现的一种神秘现象——即所谓的“Grokking”。这种现象表现为,在特定条件下,模型能够突然从对训练数据的高度过拟合状态跳脱出来,展现出对未见过的数据的良好泛化能力。最近,一篇题为《透过压缩洞察突现泛化:基于最小描述长度原理探究突然泛化现象》的研究报告为我们提供了一种全新的视角来理解这一过程。 该研究提出,利用信息论中的最小描述长度(Minimum Description Length, MDL)原则可以有效解释Grokking现象。MDL原则强调,在不影响描述准确性的前提下,选择最简洁的模型来进行数据编码。研究发现,当神经网络学习到一定程度时,其权重分布会逐渐趋于一种更为简洁的状态,从而使得整个模型的描述长度达到最短。这不仅意味着模型的复杂度降低,更重要的是,它揭示了模型如何从对训练数据的高度依赖转变为具备更强泛化能力的过程。 这项研究对于深入理解深度学习模型的工作机制具有重要意义,并为未来设计更加高效、泛化的机器学习算法提供了理论基础。此外,它也提醒我们,在追求模型性能的同时,不应忽视对模型复杂性和泛化能力之间平衡的考量。通过这种方式,我们可以期待在未来开发出更加强大且稳健的人工智能系统。

根据描述,这篇论文的想法由Claude 3.5 Sonnet在第22次迭代时提出。

该研究主要探讨了神经网络中的最小描述长度(MDL)原理与“grokking”现象之间的关系,即模型在长时间训练后为何会突然具备更好的泛化能力。研究从信息论的角度分析了这一突然泛化机制的背后原因。

其中,MDL(最小描述长度)可以被视为一种评估模型复杂度和可压缩性的手段,也就是说,模型不仅要能够很好地拟合数据,还不能太过复杂(以防止过拟合)。

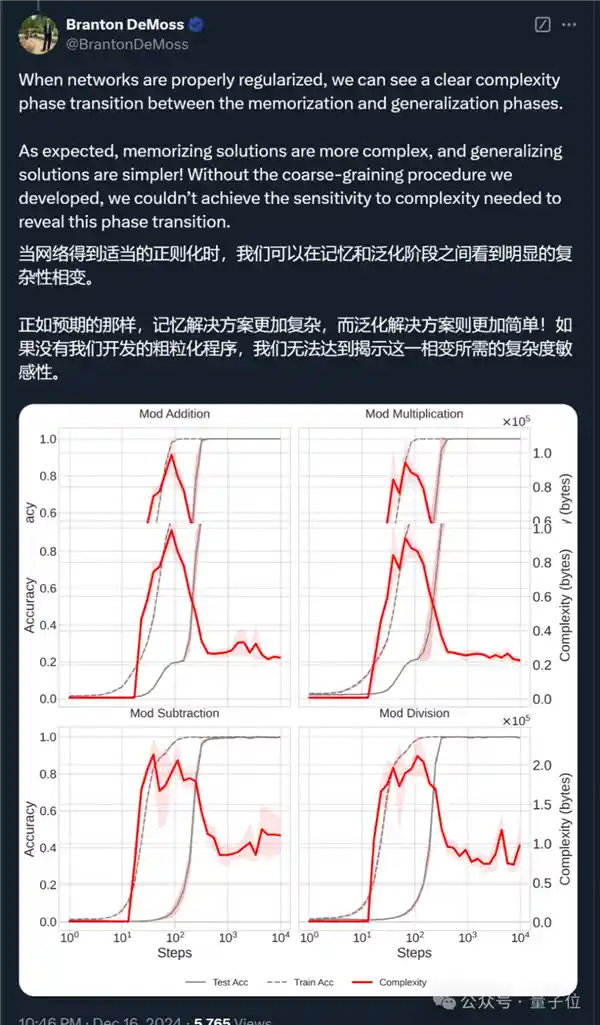

具体而言,研究引入了一种基于权重剪枝的新型MDL估计技术,并将其应用于多种数据集,包括模块化算术和排列任务。相关实验揭示了MDL减少与泛化能力提高之间存在强烈的相关性(下图),MDL的转变点通常在“grokking”事件发生之前或与之同时出现。

此外,研究观察到,在“grokking”与非“grokking”情境下,模型描述长度(MDL)的演变模式存在显著差异。在“grokking”过程中,模型会经历一个快速的MDL减少阶段,随后进入一个稳定的泛化期。这一发现为深入理解“grokking”的信息论基础提供了新的视角,并且表明在训练过程中监控MDL的变化,可以作为预测模型泛化的有效手段。 在我看来,这项研究不仅加深了我们对神经网络训练过程中的复杂现象的理解,而且为优化模型训练策略提供了潜在的理论依据。通过实时监测MDL指标,研究人员和工程师能够更早地识别出模型可能达到的最佳泛化状态,从而提高模型在实际应用中的性能和稳定性。此外,这种方法也为未来探索更高效、更智能的机器学习算法提供了新的研究方向。

Okk,了解了原论文,我们再来看人类选手最新发表的内容。

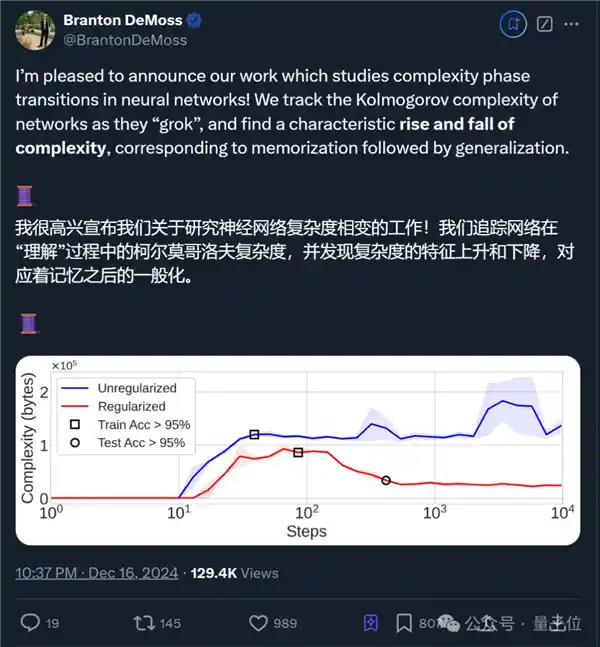

概括而言,他们深入探讨了神经网络在“grokking”现象中的复杂性变化,即网络从单纯记忆训练数据到实现全面泛化的转变过程,并提出了一种新颖的方法来衡量神经网络的复杂性,这种方法基于失真压缩理论。这项研究揭示了神经网络如何逐步从依赖记忆转向真正的理解能力,这为优化网络设计提供了新的视角。这种新方法不仅能够更准确地评估神经网络的复杂度,还可能引导出更加高效和灵活的学习算法。这一发现对于理解人工智能系统的内在机制具有重要意义,未来可能推动机器学习领域的重大突破。 在我看来,这项研究不仅加深了我们对神经网络工作原理的理解,而且为改进现有模型提供了潜在的新途径。通过引入失真压缩理论作为衡量标准,研究者们为我们提供了一个全新的分析框架,这对于推动机器学习技术的发展至关重要。此外,这种方法也有助于我们更好地理解AI系统如何从数据中提取有意义的信息,从而向真正的人类智能迈进了一步。

首先,作者之一Branton DeMoss自述,他们受到了Sean Carroll和Scott Aaronson之前研究的启发。

通过观察咖啡与奶油混合的过程,Scott等人发现,复杂性先是随时间逐渐升高,随后又降低,这一现象与熵不断增加的趋势类似。

而DeMoss团队形式化了这一直觉,并将其应用于神经网络,以跟踪这些网络学习的抽象复杂度。

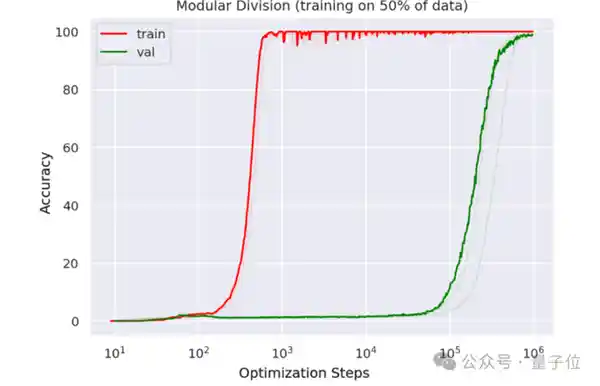

展开来说,作者们同样先介绍了grokking现象,即神经网络在长时间过度拟合训练数据后突然能够泛化的能力。

其中x轴表示迭代次数,y轴表示准确率;红线表示训练集的准确率,绿线表示验证集的准确率。

可以看到,在训练一个小规模的Transformer进行模拟时,模型在几百个训练步骤后已能够完美拟合训练数据;然而,要达到良好的泛化能力,则需要大约10万次的训练步骤。

为了阐释这一现象,研究团队提出了一种结合失真压缩和Kolmogorov复杂性的新方法,用于评估神经网络的复杂度。借助这一理论框架,他们追踪并分析了在grokking过程中网络复杂度的变化情况。

按照作者的比喻,这就像“神经网络的JPEG”。

研究发现,网络在从记忆到泛化的转变过程中,其复杂性先是增加,随后在泛化实现时降低。

进一步地,研究发现如果神经网络没有任何形式的正则化(一种防止过拟合的技术),它将无法从记忆阶段过渡到泛化阶段,而是会无限期地保持记忆模式。

没有正则化的反应:

有正则化的反应:

此外,作者指出传统的复杂性评判标准(如参数数量和权重范数)并不能准确描述模型的复杂性,因为它们忽略了训练过程中的变化。

对此,他们采用了最小描述长度(MDL)原则和Kolmogorov复杂度来定义和近似复杂性,并通过实验验证了这种方法,并强调了简单模型在数据压缩中的优势。

最终,研究发现,掌握复杂性对于提升预测模型的泛化能力极为关键。

更多细节感兴趣可以查阅原论文(地址文末)。

可以看出,一项由人工智能最初提出的想法,最终经由人类完成了更为细致的论证过程。

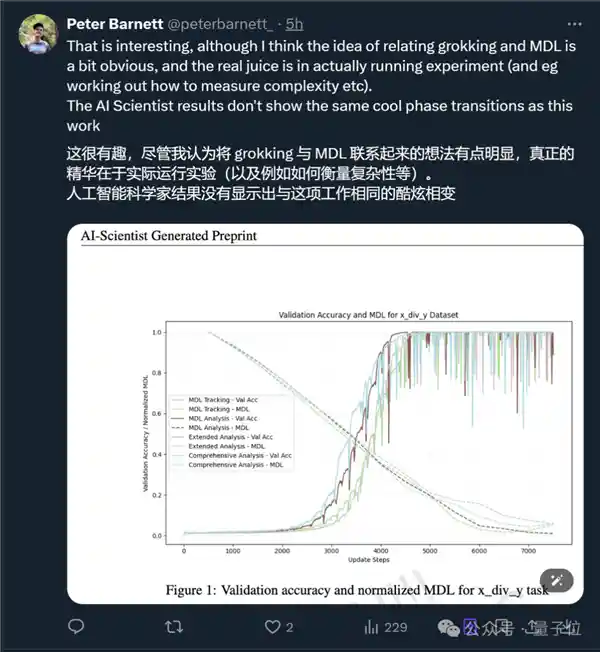

有观察者分析认为,AI撰写的实验结果不如人类研究员所撰写的结果详尽和深入。

而之前撰写过“AI科学家”总论文的共同一作Cong Lu也表示:

谁知道未来AI还会激发出哪些其他想法……

BTW,近日,SakanaAI宣布其“AI科学家独立生成10篇学术论文”的项目取得成功。紧接着在9月份,公司顺利完成了一轮2亿美元的A轮融资,其中还包括了英伟达的投资。

总之,AI未来不仅能够独立撰写论文,还能够与人类协同工作。

论文:https://arxiv.org/abs/2412.09810

免责声明:本站所有文章来源于网络或投稿,如果任何问题,请联系648751016@qq.com

页面执行时间0.008903秒