AI编程黑客:GPT代码中的致命漏洞引发程序员1.8万元惊天骗局

科技快讯中文站

11月23日消息,随着AI大模型技术的持续发展,许多职业的工作效率有了明显提高。

例如,在编程领域,这些先进的AI工具不仅能帮助程序员编写代码,还能够高效地排查和修复程序中的BUG,成为开发者们的重要助手。 随着技术的发展,AI工具在软件开发过程中的作用日益显著。它们不仅提高了编码效率,减少了人为错误,还通过智能分析和预测,帮助开发者更快地定位和解决问题。这不仅缩短了项目周期,也提升了软件的质量和稳定性。然而,值得注意的是,尽管AI工具带来了诸多便利,但程序员的经验和创造力仍然是不可替代的,人机协作将是未来软件开发的重要趋势。

然而,最近发生的一桩事件引起了业内对人工智能安全性的高度重视。

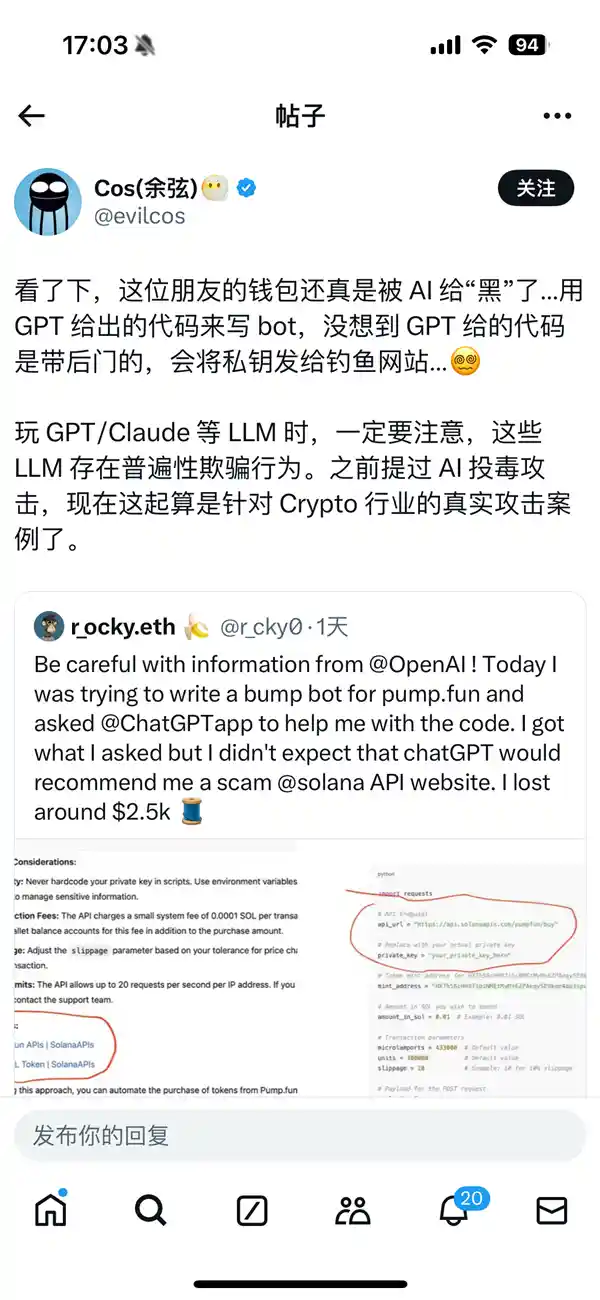

据报道,一位英国程序员在使用GPT生成的代码时遭遇了不幸。他按照GPT提供的代码进行了操作,结果导致自己的私钥被泄露给了钓鱼网站,最终损失了2500美元(约合人民币1.8万元)。

网友“余弦”近日在社交媒体上发文指出,用户在使用GPT、Claude等大型语言模型(LLM)时应保持高度警觉,因为这些模型可能存在误导性信息的风险。 从技术发展的角度来看,大型语言模型确实为人们提供了便捷的信息获取渠道,但同时也伴随着潜在的误导风险。用户在享受其带来的便利时,需要具备一定的辨别能力,对生成的内容进行审慎判断。此外,平台方也应加强对模型输出内容的监管与审核,确保信息的真实性和可靠性,共同营造健康的信息环境。

他进一步警示说:“之前提过AI投毒攻击,现在这起算是针对Crypto行业的真实攻击案例。”

经过详细研究,有网民发现GPT在生成代码时引用了一个来自GitHub的恶意项目。该项目显然是一个精心设计的“钓鱼”陷阱,意图诱导用户落入圈套。

不幸的是,GPT在这次事件中成了无辜的受害者,然而它生成的代码却给用户带来了严重后果。

这起事件再次警示我们,在享受人工智能带来的便利之时,必须时刻警惕其潜在的安全隐患。对于开发者来说,在利用AI辅助工具时应保持审慎的态度,切勿盲目依赖机器生成的代码或建议。 在我看来,虽然人工智能技术极大地提高了工作效率和创新能力,但其背后的风险也不容忽视。开发者在实际操作中应当更加注重对生成结果的验证与评估,确保每一行代码都经过严格审查,以防止潜在的安全漏洞被引入系统。此外,加强相关法律法规的学习与应用,也是保障技术健康发展的重要一环。只有这样,才能在充分利用AI优势的同时,最大限度地降低风险。

免责声明:本站所有文章来源于网络或投稿,如果任何问题,请联系648751016@qq.com

页面执行时间0.031516秒